Top 168澳洲10平台官网

Maritime

168官网澳洲10开奖记录查询-官方开奖结果直播 Shipping and geopolitical risk: Don’t forget about Korean Peninsula

168网澳洲幸运10开奖结果 the focus on wars in Europe and the Middle East, North Korea’s threat to key exporting and shipbuilding nations grows.

Less than Truckload (LTL)

Forward Air, Omni reach settlement; merger to close soon

Mexico Borderlands

Borderlands: Nearshoring forecast to boost US-Mexico trade in 2024

Chart of the Week

Rejection rates bounce higher after Arctic plunge

Electric Trucks

No signs of panic as Nikola gets 2nd Nasdaq delisting warning

Technology

Flexport raises $260M from Shopify

幸运澳洲十官方开奖历史号码记录+手机开奖号码结果 SONAR High-Frequency Supply Chain Data

| Market | Percent Change | *Today’s Value | Last value |

|---|---|---|---|

| MQFWSCTP.USASupply Chain Tech Index | 0.01 | $3796.39 | $3754.97 |

| Market | Percent Change | *Today’s Value | Last value |

|---|---|---|---|

| IMOTRI.LAXIntermodal Outbound LA Tender Rejection Rate | 0 | 0.17% | 0.17% |

| IMOTRI.CHIIntermodal Outbound CHI Tender Rejection Rate | 0 | 0% | 0% |

Weekly NTI Update: September 26, 2022

FreightWaves Pricing Power Index

奥洲体彩幸运十体彩视频app Crosswinds threaten soft landing

The 澳洲幸运10全天稳定计划官方版下载- imbalance between supply and demand has yet to be corrected, such that only an unprecedented tidal wave of demand could satisfy the current amount of capacity in the national freight economy.

FreightWaves Pricing Power Index

Better late than never

FreightWaves Pricing Power Index

It’s beginning to look a lot like … 2021?

Chart of the Week

The one pandemic-era trend that has stuck

澳洲体彩幸运10开奖PC版 SONAR Analyst Reports

Ocean carriers’ record rejections last-ditch effort to bolster spot rates

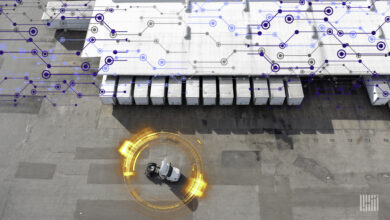

SONAR’s Container Atlas shows new booking volumes plummeting over 35% from their Aug. 1 peak, a key indicator that U.S. import demand is rapidly deteriorating. (Photo: Jim Allen/FreightWaves)

Contract rate decline takes pause despite significant spot market discount

Transportation providers are going to have to maintain an aggressive posture when competing for business during the upcoming bid season.

Ocean carriers steadily losing pricing power in trans-Pacific

Ocean carriers are steadily losing pricing power on the trans-Pacific as China to U.S. demand peaks for the second half of 2023.